Traditionelle Qualitätsprüfung stößt an ihre Grenzen. Ein menschlicher Prüfer kann in einer 8-Stunden-Schicht etwa 2.000-3.000 Bauteile inspizieren – bei sinkender Aufmerksamkeit gegen Ende der Schicht. Die Fehlererkennungsrate liegt selbst bei erfahrenen Prüfern nur bei 70-85%, je nach Komplexität und Ermüdungsgrad. Subjektive Bewertungen führen zu Inkonsistenzen: Was Prüfer A als akzeptabel einstuft, klassifiziert Prüfer B als Ausschuss.

KI-gestützte Qualitätsprüfung ändert diese Gleichung fundamental. Systeme mit Deep Learning erreichen Erkennungsraten von 95-99,5%, prüfen bis zu 200 Teile pro Minute und arbeiten 24/7 ohne Leistungsabfall. Sie erkennen Muster, die menschliche Prüfer übersehen, und liefern objektive, reproduzierbare Ergebnisse. In diesem Artikel erfahren Sie:

- Wie KI-gestützte Qualitätsprüfung funktioniert und welche Technologien zum Einsatz kommen

- Die 5 Hauptanwendungsbereiche – von Oberflächeninspektion bis Maßhaltigkeit

- Welche KI-Algorithmen verwendet werden (CNN, YOLO, SSD) und wie sie sich unterscheiden

- Regelbasierte vs. KI-basierte Systeme: Wann ist welcher Ansatz richtig?

Was ist KI-gestützte Qualitätsprüfung wirklich?

Der Begriff „KI in der Qualitätskontrolle“ wird oft inflationär verwendet – für simple Schwellwertvergleiche ebenso wie für hochkomplexe neuronale Netze. Echte KI-gestützte Qualitätsprüfung unterscheidet sich von traditioneller, regelbasierter Bildverarbeitung durch drei Kernmerkmale: Lernfähigkeit, Muster erkennung ohne explizite Programmierung und Generalisierung auf ungesehene Defekttypen.

Abgrenzung zur klassischen Bildverarbeitung

Klassische industrielle Bildverarbeitungssysteme arbeiten nach dem Prinzip „Wenn-Dann-Regeln“: „Wenn Pixelhelligkeit im Bereich X liegt UND Konturengröße größer als Y, DANN klassifiziere als Defekt.“ Diese Regeln müssen von Ingenieuren manuell definiert und bei jeder Änderung der Produkteigenschaften angepasst werden. Das funktioniert gut für standardisierte Prüfaufgaben mit gleichbleibenden Bedingungen.

KI-basierte Systeme hingegen lernen aus Beispielen. Sie analysieren tausende Bilder von „guten“ und „schlechten“ Teilen und extrahieren selbstständig die relevanten Merkmale. Das System erkennt komplexe Muster – etwa dass bestimmte Farbverläufe typischerweise mit späteren Funktionsausfällen korrelieren – ohne dass ein Mensch diese Zusammenhänge explizit programmieren muss.

Die Rolle des maschinellen Sehens (Computer Vision)

KI-Qualitätsprüfung basiert auf Computer Vision – der Fähigkeit von Computern, visuelle Informationen zu interpretieren. Während traditionelle Bildverarbeitung auf handgefertigten Features basiert (Kanten, Ecken, Texturen), extrahieren moderne Deep-Learning-Systeme hierarchische Features automatisch:

- Niedrige Ebenen (frühe Netzwerkschichten): Kanten, Farben, einfache Texturen

- Mittlere Ebenen: Objektteile, Muster, geometrische Formen

- Hohe Ebenen (tiefe Schichten): Komplette Objekte, semantische Konzepte („Kratzer“, „Pore“, „Einschluss“)

Dieser hierarchische Aufbau ermöglicht es, sowohl einfache als auch hochkomplexe Defekte zu erkennen – von offensichtlichen Rissen bis zu subtilen Oberflächenanomalien, die nur durch Kombination vieler Merkmale erkennbar sind.

Kerntechnologien: Welche KI-Algorithmen kommen zum Einsatz?

KI-gestützte Qualitätsprüfung ist kein monolithisches System, sondern nutzt verschiedene Algorithmen je nach Anwendungsfall. Die drei wichtigsten Kategorien:

1. Convolutional Neural Networks (CNN) für Klassifikation

CNNs sind die Arbeitspferde der Bildklassifikation. Sie bestehen aus mehreren Schichten von Faltungs-Operationen (Convolutions), die Features extrahieren, gefolgt von Pooling-Schichten zur Dimensionsreduktion und vollständig verbundenen Schichten für die finale Klassifikation.

Typische Architekturen:

- ResNet-50: 50 Schichten tief, nutzt „Skip Connections“ um das Vanishing-Gradient-Problem zu vermeiden. Sehr robust für industrielle Anwendungen.

- MobileNet: Leichtgewichtige Architektur, optimiert für Edge-Computing auf ressourcenbeschränkten Geräten (z.B. direkt an der Kamera).

- EfficientNet: Optimales Balance zwischen Genauigkeit und Rechenaufwand durch systematische Skalierung von Netzwerktiefe, -breite und Auflösung.

💡 Praxisbeispiel: CNN für Oberflächenklassifikation

Anwendung: Automotive-Zulieferer, Lackierte Kunststoffteile (Armaturenbretter)

Problem: 12 verschiedene Defekttypen (Kratzer, Einschlüsse, Orangenhaut, Staubeinschluss, etc.), sehr variable Erscheinungsformen

Lösung: ResNet-50, trainiert auf 45.000 klassifizierten Bildern (3.750 pro Defektklasse)

Ergebnis:

- Erkennungsrate: 97,8% (vs. 82% bei manuellerPrüfung)

- Prüfzeit: 0,3 Sekunden/Teil (vs. 8-12 Sekunden manuell)

- Ausschussreduktion: -42% (weniger Falsch-Positiv-Entscheidungen)

- ROI erreicht nach 11 Monaten

2. Object Detection: YOLO, SSD und Faster R-CNN

Wenn nicht nur die Klassifikation („Ist ein Defekt vorhanden?“), sondern auch die Lokalisierung („Wo genau ist der Defekt?“) wichtig ist, kommen Object Detection Algorithmen zum Einsatz.

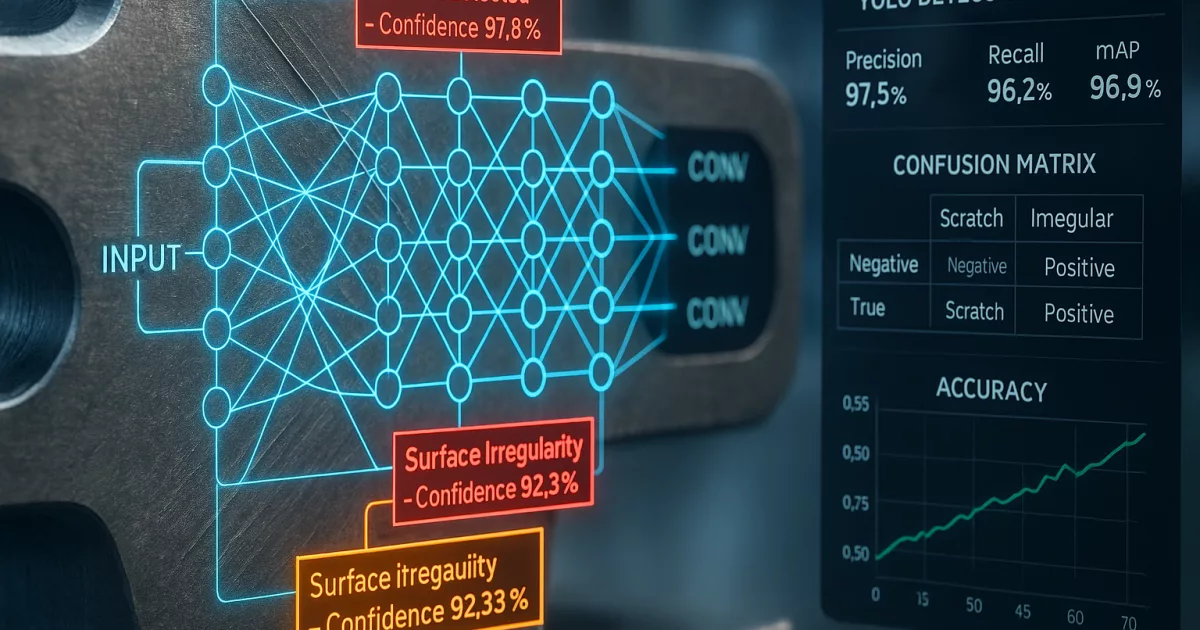

YOLO (You Only Look Once) ist der Goldstandard für Echtzeit-Defekterkennung. Anders als ältere Verfahren (R-CNN), die das Bild zuerst in Regions of Interest aufteilen, analysiert YOLO das gesamte Bild in einem einzigen Durchlauf. Stand 2025 ist YOLOv11 aktuell, mit folgenden Verbesserungen:

| YOLO-Version | Erscheinungsjahr | Hauptinnovation | Geschwindigkeit (FPS) | Genauigkeit (mAP) |

|---|---|---|---|---|

| YOLOv1 | 2015 | Erste Echtzeit-Objekterkennung | 45 FPS | 63,4% |

| YOLOv3 | 2018 | Multi-Scale-Detektion | 30 FPS | 57,9% (COCO) |

| YOLOv5 | 2020 | PyTorch-Implementation, Auto-Anchor | 140 FPS | 50,7% (COCO) |

| YOLOv8 | 2023 | Anchor-Free Design, verbesserte Backbone | 280 FPS (Nano) | 53,9% (COCO) |

| YOLOv11 | 2024 | Transformer-Integration, bessere Kleinteile-Erkennung | 300+ FPS | 56,2% (COCO) |

SSD (Single Shot MultiBox Detector) ist eine Alternative zu YOLO, die mehrere Feature-Maps unterschiedlicher Auflösungen nutzt. Vorteil: Bessere Erkennung kleiner Objekte. Nachteil: Etwas langsamer als YOLO.

Faster R-CNN ist ein Two-Stage-Detektor: Erst werden Regionen vorgeschlagen (Region Proposal Network), dann klassifiziert. Genauer als YOLO/SSD, aber langsamer (10-20 FPS statt 100+). Wird eingesetzt, wenn höchste Genauigkeit wichtiger ist als Geschwindigkeit.

3. Semantic Segmentation für pixelgenaue Defekterkennung

Bei manchen Anwendungen reicht es nicht, einen Defekt zu lokalisieren – man muss ihn pixelgenau segmentieren. Beispiele: Schweißnahtprüfung, Rissanalyse, Beschichtungsqualität.

U-Net ist die dominierende Architektur für Semantic Segmentation. Ursprünglich für medizinische Bildanalyse entwickelt, wird U-Net auch in der industriellen Qualitätsprüfung breit eingesetzt. Die Architektur besteht aus:

- Encoder (Downsampling-Pfad): Extrahiert Features und reduziert räumliche Dimensionen

- Decoder (Upsampling-Pfad): Rekonstruiert pixelgenaue Segmentierung

- Skip Connections: Verbinden Encoder und Decoder direkt, um feine Details zu bewahren

Neuere Architekturen:

- DeepLabv3+: Nutzt Atrous Convolutions für größere rezeptive Felder

- Mask R-CNN: Kombination aus Object Detection und Segmentation

- Segment Anything Model (SAM) von Meta: Foundation Model, das mit wenigen Beispielen für neue Defekttypen adaptiert werden kann

| Algorithmus-Typ | Hauptanwendung | Typische Rechenzeit | Genauigkeit | Einsatzbereich |

|---|---|---|---|---|

| CNN (ResNet, EfficientNet) | Bildklassifikation („gut/schlecht“) | 10-50 ms | 95-99% | Endkontrolle, sortieren |

| YOLO (v8, v11) | Defektlokalisierung Echtzeit | 3-10 ms | 92-97% | Inline-Prüfung, Roboter-Guidance |

| Faster R-CNN | Hochpräzise Defekterkennung | 50-100 ms | 96-99% | Offline-Prüfung, Audit |

| U-Net / DeepLab | Pixelgenaue Segmentierung | 80-200 ms | 94-98% (IoU) | Schweißnaht, Risse, Beschichtung |

| Anomalie-Detektion (VAE, GANs) | Unbekannte Defekte erkennen | 20-80 ms | 85-95% | Neue Produkte, seltene Fehler |

Die 5 Hauptanwendungsbereiche der KI-Qualitätsprüfung

1. Oberflächeninspektion

Die Prüfung von Oberflächen ist der mit Abstand häufigste Anwendungsfall für KI in der Qualitätskontrolle. Typische Defekte: Kratzer, Dellen, Verfärbungen, Einschlüsse, Poren, Unebenheiten, Kontaminationen.

Warum KI hier besonders effektiv ist:

Oberflächendefekte sind extrem variabel in Erscheinungsform, Größe und Kontrast. Ein Kratzer kann 0,1 mm oder 10 mm lang sein, hell oder dunkel erscheinen (je nach Beleuchtung), scharf oder verwaschen. Regelbasierte Systeme müssten hunderte Parameter definieren – KI lernt diese Variabilität aus Daten.

💡 Praxisbeispiel: Lackinspektion in der Automobilindustrie

Hersteller: Tier-1-Zulieferer, 1,2 Mio. lackierte Teile/Jahr

Herausforderung: 8 verschiedene Lackfarben, 15 Defekttypen, Metallic- und Perleffekt-Lacke extrem schwer zu prüfen

Bisherige Lösung: 6 manuelle Prüfer, Erkennungsrate 79%, hohe Fehlerkosten durch übersehene Defekte (Reklamationsquote 2,4%)

KI-Lösung: 4 Hochauflösungskameras (12 MP), Multispektral-Beleuchtung (UV + Visible + Infrarot), YOLOv8 + EfficientNet-Ensemble

Training: 120.000 annotierte Bilder über 6 Monate gesammelt, Data Augmentation (Rotation, Helligkeitsvariation, Rauschen) auf 480.000 Bilder erweitert

Ergebnis nach 12 Monaten:

- Erkennungsrate: 98,2% (Steigerung um 19 Prozentpunkte)

- Falsch-Positiv-Rate: 1,8% (vs. 12% vorher – weniger unnötiger Ausschuss)

- Reklamationsquote: 0,3% (-87,5%)

- Einsparung: ca. 680.000 € / Jahr (Ausschussreduktion + weniger Reklamationen)

- Personaleffekte: 3 Prüfer umgeschult zu „KI-Supervisoren“ (überwachen System, markieren Edge-Cases für Nachtraining)

Typische Oberflächendefekte und Erkennungsmethoden

| Defekttyp | Erscheinungsform | Herausforderung | KI-Ansatz | Erkennungsrate |

|---|---|---|---|---|

| Kratzer | Lineare Strukturen, variabel in Länge/Breite | Abgrenzung zu Spiegelungen, Haarrissen | CNN + Edge Detection Pre-Processing | 96-99% |

| Dellen | Lokale Verformungen, Schattenwurf | Stark beleuchtungsabhängig | 3D-Scanner + CNN oder Photometric Stereo | 93-97% |

| Poren/Einschlüsse | Kleine Punkte (0,1-2 mm) | Ähnlich zu Verschmutzung, niedrige Kontrast | Hochauflösende Kameras + YOLO (für Lokalisierung) | 94-98% |

| Verfärbungen | Farbabweichungen, ungleichmäßige Tönung | Subjektive Bewertung, Akzeptanzgrenzen unklar | Spektralkameras + CNN für Farbanalyse | 91-95% |

| Orangenhaut (Lackierung) | Wellige Oberfläche, Glanzunterschiede | Sehr subtil, nur unter bestimmten Winkeln sichtbar | Deflektometrie + Deep Learning auf Phasenkarten | 88-94% |

2. Defekterkennung in der Produktion

Während Oberflächeninspektion primär ästhetische Mängel betrifft, geht es bei Defekterkennung um funktionskritische Fehler: Risse, Brüche, Fehlbohrungen, falsche Bauteile, fehlende Komponenten.

Typische Anwendungen:

- Schweißnahtprüfung: Erkennung von Poren, Rissen, unvollständigen Durchschweißungen, Spritzern

- Gussfehlererkennung: Lunker, Einschlüsse, Warmrisse in Gussteilen (oft mit Röntgen oder CT kombiniert)

- Leiterplatteninspektion (PCB): Fehlende Bauteile, falsche Bestückung, Lötstellen-Qualität

- Montageverifikation: Sind alle Schrauben vorhanden? Richtiger Typ? Korrekt angezogen?

💡 Praxisbeispiel: Schweißnahtprüfung mit Deep Learning

Unternehmen: Stahlbau, Schweißkonstruktionen für Offshore-Windkraftanlagen

Anforderung: 100% Dokumentation aller Schweißnähte, Detektion von Fehlern vor zerstörender Prüfung

Bisherige Lösung: Manuelle Sichtprüfung + stichprobenartige Ultraschallprüfung. Problem: 30-40% der Fehler erst bei UT erkannt → Nachschweißen teuer

KI-Lösung:

- 2 Zeilenkameras (8k Auflösung) fahren Schweißnaht ab

- U-Net Segmentation für pixelgenaue Defektklassifikation

- 5 Defektklassen: Poren, Risse, Bindefehler, Spritzer, Einbrand

- Training: 25.000 Schweißnahtbilder, annotiert von zertifizierten Schweißfachleuten

Ergebnis:

- Fehlererkennungsrate: 96,5% (vs. 65% visuell)

- Prüfzeit: 15 Sekunden/Meter (vs. 90 Sekunden manuell)

- Nachschweißquote: -58% (Fehler werden früher erkannt)

- Dokumentation: Automatisch mit Bild, Position, Klassifikation → Qualitätsakte

3. Maßhaltigkeit und Geometrieprüfung

KI wird zunehmend auch für die Prüfung von Maßen und geometrischen Toleranzen eingesetzt. Während klassische Messmaschinen (KMG) präziser sind, bieten KI-basierte Systeme Vorteile bei der 100%-Prüfung in der Serienfertigung.

Ansätze:

2D-Bildverarbeitung + Deep Learning: Erkennung von Konturen, Extraktion von Maßen. Genauigkeit typischerweise ±0,05-0,2 mm (abhängig von Kamera-Auflösung und Kalibrierung).

3D-Scanning + AI: Laserlinien-Scanner oder Structured Light erzeugen 3D-Punktwolken. CNN analysiert Abweichungen vom CAD-Modell. Genauigkeit: ±0,01-0,05 mm.

Photogrammetrie + Deep Learning: Mehrere Kameras aus verschiedenen Winkeln, 3D-Rekonstruktion, AI-basierter Vergleich mit Sollgeometrie.

4. OCR und Zeichenerkennung

Optical Character Recognition (OCR) ist ein klassisches Computer-Vision-Problem, das durch Deep Learning revolutioniert wurde. In der Qualitätskontrolle wird OCR eingesetzt für:

- Rückverfolgbarkeit: Lesen von Seriennummern, Chargennummern, 2D-Codes (Data Matrix, QR)

- Etikettenprüfung: Ist das richtige Etikett angebracht? Vollständig? Lesbar?

- Druckbildkontrolle: Qualität von Drucken, Laserbeschriftungen, Prägungen

- Typenprüfung: Verifikation, dass auf dem Teil die richtige Artikelnummer, das richtige Herstelldatum etc. aufgebracht ist

Moderne KI-OCR-Systeme basieren auf Transformer-Architekturen (z.B. TrOCR von Microsoft) oder CRNN (Convolutional Recurrent Neural Networks). Sie erreichen Erkennungsraten von 99,5-99,9% auch bei:

- Schlechter Beleuchtung oder niedrigem Kontrast

- Verzerrten oder geneigten Texten

- Beschädigten oder teilweise verdeckten Zeichen

- Verschiedenen Schriftarten ohne explizite Konfiguration

| OCR-Typ | Technologie | Lesegeschwindigkeit | Erkennungsrate | Anwendungsbereich |

|---|---|---|---|---|

| 1D-Barcode | Klassische Algorithmen (ausreichend) | < 50 ms | 99,9% | EAN, Code 128, Code 39 |

| 2D-Code (Data Matrix, QR) | Reed-Solomon Error Correction + AI für beschädigte Codes | 50-150 ms | 99,7-99,9% | Lasergravur, DPM (Direct Part Marking) |

| Alphanumerisch (klar) | CNN-basiertes OCR (Tesseract 5, EasyOCR) | 100-300 ms | 99,5-99,8% | Etiketten, Drucke, Prägungen |

| Alphanumerisch (schwierig) | TrOCR, PaddleOCR (Transformer-basiert) | 200-500 ms | 98,5-99,5% | Handschrift, verblasste Texte, verzerrte Aufdrucke |

| Spezialschriften / Symbole | Custom-trained CNN | 150-400 ms | 97-99% | Firmenlogos, Sonderzeichen, asiatische Schriftzeichen |

💡 Praxisbeispiel: Rückverfolgbarkeit in der Elektronikfertigung

Unternehmen: Leiterplattenfertiger, 50.000 PCBs/Tag

Anforderung: 100% Lesung aller Data-Matrix-Codes + alphanumerische Seriennummern für vollständige Traceability

Herausforderung: Codes auf verschiedenen Untergründen (grün, schwarz, gold), teils reflektierend, teils durch Lötrauch leicht verschmutzt

Lösung:

- 2 Kameras pro Prüfstation (verschiedene Beleuchtungswinkel)

- PaddleOCR für alphanumerische Zeichen

- Libdmtx + Deep Learning für Data-Matrix (Fallback bei beschädigten Codes)

- Automatische Plausibilitätsprüfung (Seriennummer muss zu Charge passen)

Ergebnis:

- Leserate: 99,92% (vorher 98,3% → 1,62 Prozentpunkte Verbesserung klingt wenig, sind aber 800 Teile/Tag weniger Nacharbeit)

- No-Read-Rate: 0,08% (werden automatisch zur manuellen Prüfstation geleitet)

- Vollständige Dokumentation in Datenbank für Reklamationsmanagement

5. Sortierung und Klassifikation

Oft geht es nicht um die Frage „Gut oder Schlecht?“, sondern um die Klassifikation in mehrere Kategorien. Typische Anwendungen:

- Farbsortierung: Kunststoffgranulate, Recyclingstrom, Lebensmittel nach Reifestufe

- Größensortierung: Schrauben, Muttern, Holzpellets nach Durchmesser

- Qualitätsklassen: A-Ware (perfekt), B-Ware (kleine Mängel, Second-Grade), C-Ware (Ausschuss)

- Materialerkennung: Verschiedene Kunststofftypen (PE, PP, PET) für Recycling, Metalllegierungen

KI-Ansatz: Multi-Class Classification mit CNN. Das Netzwerk lernt, ein Eingangsbild einer von N Klassen zuzuordnen. Typischerweise Softmax-Aktivierung in der Ausgabeschicht, die Wahrscheinlichkeiten für jede Klasse liefert.

Regelbasierte vs. KI-basierte Systeme: Wann ist welcher Ansatz richtig?

Die wichtigste Frage bei jedem Qualitätsprüfungsprojekt: Brauchen wir wirklich KI, oder reicht ein klassisches regelbasiertes System? Die Antwort hängt von mehreren Faktoren ab.

Entscheidungsmatrix: Regelbasiert vs. KI

| Kriterium | Regelbasiert empfohlen | KI empfohlen |

|---|---|---|

| Defekttypen | 1-3 klar definierte Defekte (z.B. „Ist Loch vorhanden?“) | 5+ Defekttypen oder Defekte mit hoher Variabilität |

| Produktvarianz | Identische Teile, stabile Produktion | Hohe Variantenvielfalt, häufige Produktwechsel |

| Umgebungsbedingungen | Kontrollierte Beleuchtung, fixierte Position | Variable Beleuchtung, Lagetoleranz, Verschmutzung |

| Akzeptanzkriterien | Objektiv messbar (z.B. „Durchmesser 10±0,1mm“) | Subjektiv oder komplex (z.B. „sieht gut aus“, „Farbeindruck harmonisch“) |

| Trainingsdaten | Schwer zu beschaffen (neue Produkte, seltene Fehler) | Ausreichend Daten verfügbar (> 1.000 Bilder pro Klasse) |

| Entwicklungszeit | Schneller Projektstart wichtig (1-4 Wochen) | Zeit für Datensammlung und Training vorhanden (3-6 Monate) |

| Erklärbarkeit | Prüflogik muss vollständig nachvollziehbar sein (regulatorische Anforderungen) | „Black Box“ akzeptabel, solange Ergebnis stimmt |

| Hardware-Budget | < 20.000 € (einfache Kamera + IPC ausreichend) | > 30.000 € (GPU-Hardware für Inferenz, evtl. High-End-Kameras) |

Hybride Ansätze: Das Beste aus beiden Welten

In der Praxis setzen viele erfolgreiche Systeme auf eine Kombination aus regelbasierten und KI-basierten Methoden:

Szenario 1: Vorfilterung durch Regeln, Feinanalyse durch KI

- Regelbasiertes System macht schnelle Grobprüfung (z.B. „Ist überhaupt ein Objekt im Bild?“)

- Nur verdächtige Fälle werden an KI weitergeleitet für detaillierte Analyse

- Vorteil: Höhere Durchsatzrate, KI-Ressourcen werden geschont

Szenario 2: KI für Detektion, Regeln für Klassifikation

- KI erkennt und lokalisiert Defekte

- Regelbasierte Nachverarbeitung klassifiziert nach Größe, Position, Form

- Beispiel: „KI findet Kratzer, Regeln entscheiden: < 2mm = akzeptabel, > 2mm = Ausschuss“

Szenario 3: Ensemble-Methoden

- Mehrere Algorithmen (regelbasiert + verschiedene KI-Modelle) prüfen parallel

- Voting-Mechanismus oder gewichtete Kombination der Ergebnisse

- Vorteil: Höchste Robustheit, Ausgleich von Schwächen einzelner Methoden

💡 Praxisbeispiel: Hybrides System in der Blechbearbeitung

Unternehmen: Laserschneiden + Abkanten, 5.000 Teile/Tag, 800 verschiedene Artikel

Prüfaufgabe: Vollständigkeit (alle Bohrungen vorhanden?), Gratbildung (< 0,2mm akzeptabel), Oberflächenschäden

Lösung:

- Stufe 1 (Regelbasiert, 80ms): Template Matching prüft Bohrungspositionen gegen CAD. Einfach, schnell, 100% zuverlässig für diese Aufgabe.

- Stufe 2 (KI, 150ms): YOLOv8 sucht nach Gratbildung und Oberflächenschäden. Diese sind zu variabel für Regeln.

- Stufe 3 (Regelbasiert, 50ms): Gemessene Gratlänge wird klassifiziert: < 0,2mm OK, 0,2-0,5mm B-Ware, > 0,5mm Ausschuss

Ergebnis: Gesamtprüfzeit 280ms/Teil = 214 Teile/Minute möglich. Erkennungsrate 97,5%, deutlich robuster als rein regelbasiertes System (vorher: 89% Erkennungsrate, viele Fehlalarme bei unterschiedlichen Blechqualitäten).

Total Cost of Ownership (TCO): Regelbasiert vs. KI

Ein oft übersehener Aspekt bei der Entscheidung ist der langfristige Aufwand:

| Kostenposition | Regelbasiertes System | KI-basiertes System |

|---|---|---|

| Initiale Entwicklung | 8.000 – 35.000 € (2-4 Wochen Programmierung) | 25.000 – 80.000 € (Datensammlung 2-3 Monate, Training 2-4 Wochen) |

| Hardware | 10.000 – 25.000 € (Kamera + IPC + Beleuchtung) | 20.000 – 60.000 € (+GPU, evtl. bessere Kameras) |

| Anpassung bei Produktwechsel | 5.000 – 15.000 € (2-5 Tage Neuprogrammierung) | 2.000 – 8.000 € (neue Bilder aufnehmen, Nachtraining 1-2 Tage) |

| Wartung / Jahr | 3.000 – 8.000 € (Anpassungen bei Prozessänderungen) | 2.000 – 5.000 € (gelegentliches Nachtraining) |

| Know-how-Abhängigkeit | Hoch (nur Original-Entwickler versteht Code vollständig) | Mittel (Modelle können von anderen Data Scientists angepasst werden) |

| TCO über 5 Jahre | 45.000 – 125.000 € | 65.000 – 180.000 € |

Deep Dive: Transfer Learning und Few-Shot Learning

Eine der größten Hürden bei KI-Projekten: „Wir haben nicht genug Trainingsdaten!“ Speziell bei neuen Produkten oder seltenen Defekten. Hier kommen modernere Ansätze ins Spiel:

Transfer Learning: Von ImageNet zur Industrie

Das Prinzip: Statt ein neuronales Netz von Grund auf zu trainieren (was 100.000+ Bilder erfordern würde), nimmt man ein auf allgemeinen Bilddaten vortrainiertes Netz (z.B. ResNet-50 trainiert auf ImageNet mit 14 Mio. Bildern) und passt es an die spezifische Aufgabe an.

Wie es funktioniert:

- Feature Extraction: Die unteren Schichten des Netzes (die allgemeine Features wie Kanten, Texturen erkennen) werden „eingefroren“ und nicht mehr trainiert.

- Fine-Tuning: Nur die oberen Schichten (die aufgabenspezifische Features lernen) werden mit Ihren industriellen Daten nachtrainiert.

- Ergebnis: Gute Performance oft schon mit 500-2.000 Bildern pro Klasse statt 10.000+.

Few-Shot Learning: Lernen mit wenigen Beispielen

Few-Shot Learning geht noch einen Schritt weiter: Das System lernt aus nur 5-50 Beispielen pro Klasse. Typische Ansätze:

Siamese Networks: Das Netzwerk lernt nicht direkt Klassen, sondern eine „Similarity Function“. Es lernt, ob zwei Bilder ähnlich sind oder nicht. Bei einer neuen Defektklasse genügen dann wenige Beispiele – das System vergleicht neue Bilder mit diesen Referenzen.

Meta-Learning (Learning to Learn): Das System wird auf vielen verschiedenen Aufgaben trainiert und lernt dabei, wie man effizient lernt. Bei einer neuen Aufgabe konvergiert es dann sehr schnell.

Foundation Models + Prompt Engineering: Große vortrainierte Modelle (z.B. Segment Anything Model von Meta, CLIP von OpenAI) können durch einfache Prompts oder wenige Beispiele für neue Aufgaben adaptiert werden, ohne explizites Training.

💡 Praxisbeispiel: Few-Shot Learning für neue Produktvariante

Unternehmen: Kunststoffspritzguss, monatlich 2-3 neue Artikel mit jeweils eigenen Defektmustern

Problem: Für jeden neuen Artikel müssten eigentlich 5.000+ Bilder gesammelt werden → 3-6 Monate Vorlaufzeit inakzeptabel

Lösung: Few-Shot Learning System basierend auf Siamese Network

- Basis-Training auf 50 bestehenden Artikeln (insgesamt 150.000 Bilder)

- Bei neuem Artikel: 20 „gute“ Teile + 20 „schlechte“ Teile fotografieren

- System adaptiert in 2 Stunden (Nachtraining auf diese 40 Bilder)

Ergebnis: Erkennungsrate 92-95% (vs. 97-98% bei vollständigem Training, aber sofort verfügbar). Nach 2 Wochen Produktion: 500 weitere Bilder gesammelt, Nachtraining → Erkennungsrate steigt auf 97%.

Time-to-Deployment: 1 Tag statt 3-6 Monate!

Active Learning: Intelligent Daten sammeln

Nicht alle Trainingsdaten sind gleich wertvoll. Active Learning ist eine Strategie, um mit minimalem Annotationsaufwand maximale Performance zu erreichen:

Der Prozess:

- Trainiere initiales Modell mit wenigen gelabelten Daten (z.B. 500 Bilder)

- Lasse Modell auf großem Pool ungelabelter Bilder (z.B. 50.000) Vorhersagen machen

- System identifiziert die „unsichersten“ Vorhersagen (z.B. Confidence nur 55% für Klasse A vs. 45% für Klasse B)

- Nur diese unsicheren Fälle werden manuell gelabelt (z.B. 200 Bilder)

- Modell wird nachtrainiert

- Wiederhole Schritte 2-5 bis gewünschte Performance erreicht

Vorteil: Statt 10.000 Bilder blind zu annotieren (Aufwand: 100-200 Stunden), werden gezielt 2.000 informative Bilder ausgewählt und annotiert (20-40 Stunden) – bei gleicher oder besserer Performance.

—

Dies war Teil 1 des Artikels. Teil 2 behandelt die Marktübersicht führender Anbieter, die praktische Implementierung in 4 Schritten, ROI-Berechnungen und typische Herausforderungen mit Lösungen.

Schreibe einen Kommentar